AMD анонсирует OLMo, свою первую полностью открытую программу LLM

Компания AMD установила ещё один флаг на границе возможностей ИИ, анонсировав серию больших языковых моделей (LLM), известных как AMD OLMo. Как и другие LLM, такие как GPT 4o от OpenAI, LLM от AMD, обученная собственными силами, обладает способностью рассуждать и общаться в чате. Языковая модель с открытым исходным кодом доступна для скачивания и может работать на графических процессорах Instinct MI250 и ПК Ryzen AI с нейропроцессорами (NPUs). AMD также предоставляет инфраструктуру для разработчиков ИИ, зарегистрированных в AMD Developer Cloud.

С AMD OLMo AMD, похоже, нацелена на центры обработки данных и небольшие организации. Центры обработки данных, использующие графические процессоры AMD Instinct, имеют хорошие возможности для работы с OLMo. Но предприятия, у которых нет такого оборудования, не остаются в стороне: благодаря Ryzen AI и процессорам они могут воспользоваться преимуществами OLMo на ПК. Предоставление организациям и исследователям возможности добавлять свою собственную информацию во время обучения и тонкой настройки может помочь им разработать LLM, более подходящие для их собственных нужд.

Производитель чипов предварительно обучил серию LLM с 1 миллиардом параметров с помощью кластера графических процессоров Instinct. Этот кластер состоял из 1,3 триллиона токенов на 16 узлах, каждый из которых включал четыре графических процессора Instinct MI250.

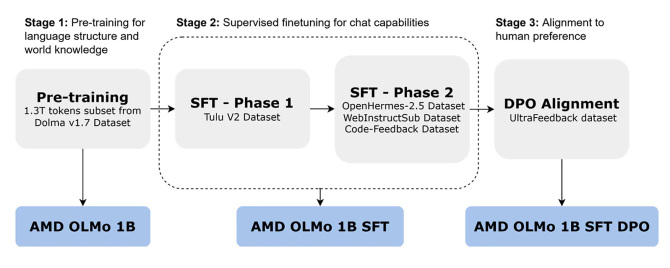

Компания AMD обучала OLMo в три этапа: предварительное обучение, этапы 1 и 2 SFT и выравнивание DPO. Модель AMD OLMo 1B обучалась на подмножестве набора данных Dolma v1.7, собирая знания и языковые шаблоны. Второй этап, OLMo 1B с контролируемой тонкой настройкой (SFT), включал два этапа обучения, направленных на повышение научных, математических и программистских способностей LLM, а также его способности следовать инструкциям. На заключительном этапе, OLMo 1B SFT DPO, AMD адаптировала LLM к человеческим предпочтениям. Это важный шаг, призванный придать LLM человеческие ценности.

Теперь давайте посмотрим на производительность OLMo 1B SFT DPO. Компания AMD провела несколько тестов и сравнила результаты с другими LLM с открытым исходным кодом. OLMo показала хорошие результаты в целом и особенно выделилась в таких тестах, как AlpacaEval2 и MT-Bench.

Что касается тестов на ответственный ИИ, то OLMo от AMD показал такие же результаты, как и другие большие языковые модели с открытым исходным кодом, такие как TinyLlama и MobileLlama. Тесты на ответственный ИИ измеряют качества, которые могут повлиять на взаимодействие человека с большими языковыми моделями. TruthfulQA-mc2, как и следовало ожидать, измеряет правдивость утверждений. ToxiGen, с другой стороны, измеряет распространённость токсичных высказываний. (Чем ниже баллы, тем лучше для теста ToxiGen.) OLMo, похоже, готов к использованию разработчиками и инновациям. AMD предлагает эту модель скачать бесплатно.

Если вы нашли ошибку, пожалуйста, выделите фрагмент текста и нажмите Ctrl+Enter.

Редактор: AndreyEx