Nvidia исправила недостатки дизайна чипов Blackwell AI

Nvidia объявила, что у нее возникли некоторые проблемы с дизайном графических процессоров Blackwell, которые впоследствии повлияли на производство. Генеральный директор сообщил новость, заявив, что бренд объединился с TSMC для устранения проблемы. По словам Дженсена Хуанга, чипы Blackwell AI должны поступить в продажу к концу этого года.

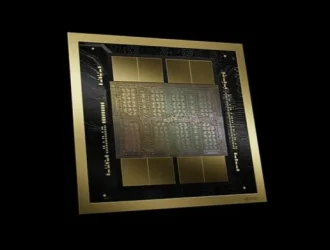

Слухи о проблемах Nvidia с ее последней архитектурой GPU оказались верными. Архитектура Blackwell, на которой работают ее последние AI GPU, по-видимому, страдала от конструктивного недостатка, который повлиял на производство. Это вызвало задержку поставок чипов, что потенциально повлияло на графики крупных клиентов, таких как Meta, Microsoft и Alphabet.

«Он был функционален, но из-за недостатка конструкции выход продукции был низким. Это была 100% вина Nvidia», — говорит Дженсен. «Чтобы заставить работать компьютер Blackwell, семь различных типов чипов были разработаны с нуля и должны были быть запущены в производство одновременно».

К счастью, Nvidia выявила проблему и исправила ее с помощью производителя чипов TSMC. Взяв на себя полную ответственность за ошибку, генеральный директор также пояснил, что слухи о напряженности между Nvidia и TSMC являются ложными.

Чтобы получить представление о сложности этой задачи, графический процессор B200 может похвастаться колоссальными 208 миллиардами транзисторов, изготовленных с использованием узла 4NP от TSMC. Чтобы сделать это, Nvidia пришлось соединить два графических процессора по 104 миллиарда транзисторов вместе через соединение 10 ТБ/с. В некотором смысле это похоже на технологию Intel Foveros, используемую в процессорах Core Ultra 200.

Бренд заявляет о четырехкратном ускорении обучения модели, в 30 раз более быстром выводе и в 25 раз более высокой энергоэффективности по сравнению с чипом H100. Напоминаем, вывод — это скорость, с которой чат-бот может ответить на ваш вопрос, например. Это означает, что B200 может либо быстрее отвечать для бесперебойного пользовательского опыта, либо одновременно выполнять несколько задач на скорости H100. Не говоря уже о колоссальных 192 ГБ памяти HBM3e, которая удвоилась по сравнению с предшественником, чтобы обеспечить более сложное обучение ИИ.

Как вы можете догадаться, это не должно повлиять на потребительские GPU, поскольку они намного меньше по размеру. Тем не менее, мы бы не отказались от такого зверя на наших ПК, если бы могли себе это позволить.

Редактор: AndreyEx